Joe Mollick había pasado gran parte de su vida soñando con convertirse en un oncólogo rico y famoso, una luminaria del tratamiento del cáncer, el hombre que curaría la enfermedad para siempre. Fue una búsqueda quijotesca para el hombre de 60 años, que lo dejó derrotado y irremediablemente aislado. Recurrió a la pornografía para aliviar sus sentimientos de soledad. Cuando esos sentimientos se volvieron más severos, también lo hizo su gusto por el porno; comenzó a buscar material de abuso sexual infantil (CSAM).

Cuando la policía sorprendió por primera vez a Mollick cargando CSAM en una aplicación de mensajería llamada Kik en 2019, registraron sus dispositivos electrónicos y descubrieron un alijo de 2.000 imágenes y videos ilegales de niños y unos 800 archivos de lo que una orden de registro revisada por Forbes describió como “erótica infantil”. Los investigadores descubrieron que se había subido y almacenado material en su cuenta de iCloud, aunque Apple no fue quien notificó a la policía. Fue Kik quien proporcionó la pista que condujo a la captura de Mollick y su sentencia de dos años de prisión. La empresa fue alertada sobre las imágenes mediante una herramienta de Microsoft llamada PhotoDNA, que utiliza una huella digital para identificar CSAM conocido.

Que Apple no haya marcado el material ilegal no es sorprendente: aparte de su escaneo estándar de archivos adjuntos de correo electrónico salientes, la compañía ha optado durante mucho tiempo por no examinar los datos no cifrados de iCloud en busca de CSAM conocido. Y aunque desarrolló un sistema criptográfico para hacer precisamente eso, Apple lo abandonó a finales de 2022, una medida polarizadora que generó elogios de los defensores de la privacidad y la indignación de los defensores de la seguridad infantil. La compañía enmarcó la controvertida decisión como un reflejo de su compromiso con la privacidad, una postura que le ha valido muchos aplausos a la empresa más rica del mundo.

Aún así, los críticos dicen que Apple no ha logrado desarrollar una respuesta sostenida y exitosa a los materiales de explotación infantil en sus servicios y se ha quedado muy por detrás de sus competidores en ayudar a la policía a atrapar a los delincuentes que lo proliferan. Una revisión de Forbes de unos 100 casos federales en los que los investigadores buscaron tecnologías de Apple, creyendo que se utilizaban para promover la explotación infantil, encontró que los sistemas de la empresa se han utilizado para almacenar y transmitir miles de elementos de CSAM entre 2014 y 2023. Pero a diferencia de sus pares Al igual que Google y Meta, que escanean proactivamente sus servicios en busca de dicho material y proporcionan millones de clientes potenciales cada año al Centro Nacional para Niños Desaparecidos y Explotados (NCMEC, por sus siglas en inglés), una organización sin fines de lucro y a las fuerzas del orden, Apple reporta solo cientos a pesar de tener cientos de millones de usuarios de iCloud.

Dentro de Apple, ha habido interrupciones en su función de confianza y seguridad en los 18 meses transcurridos entre el anuncio de la tecnología anti-CSAM y su eliminación. Dos ejecutivas de seguridad infantil, Melissa Marrus Polinsky, quien pasó 10 años como directora de investigaciones y seguridad infantil de Apple, y su directora de confianza y seguridad, Margaret Richardson, se fueron. Otros dos ejecutivos que eran partes interesadas clave en el trabajo anti-CSAM de la compañía también partieron: la directora de privacidad, Jane Horvath, y el líder de iCloud, Michael Abbott. (Ninguno respondió a las solicitudes de comentarios. Apple se negó). Abhishek Bhowmick, descrito por dos ex empleados de Apple como el ingeniero principal del software de detección de CSAM, se fue para iniciar su propia empresa. Cuando se le contactó para hacer comentarios, dijo a Forbes que su trabajo en tecnología de privacidad en Apple fue "uno de los mayores honores de mi carrera".

Esas salidas fueron significativas. Cuando Polinsky y Richardson se marcharon, dejaron “huecos bastante grandes en la organización”, dijo a Forbes un ex empleado de Apple. Otro dijo que el grupo centrado en la protección infantil se había dispersado, con funciones reorganizadas y asignadas a otros equipos. Gran parte de la función se ha trasladado a la ingeniería de privacidad, según una fuente que tiene conocimiento.

Ese departamento ahora está dirigido por Erik Neuenschwander, un veterano ejecutivo técnico de Apple. Recientemente nombrado director de privacidad y seguridad infantil, sus funciones anteriores se centraron principalmente en la ingeniería de software. Junto a él trabajan Chuck Gillingham, ex fiscal de distrito adjunto del condado de Santa Clara, y Ruben van der Dussen, ingeniero de privacidad que anteriormente trabajó en Thorn, la organización sin fines de lucro anti-CSAM fundada por Ashton Kutcher. El personal de confianza y seguridad depende en última instancia de Mike Thornberry, quien ha pasado gran parte de sus 23 años en Apple supervisando las ventas y Apple Pay.

Apple ha sostenido durante mucho tiempo que la privacidad es un derecho humano fundamental. La compañía se negó a construir para el FBI una puerta trasera en iOS que eludiera varias características de seguridad importantes y permitiera a las fuerzas del orden acceder a los datos personales almacenados en los iPhone. Apple argumentó que hacerlo le daría al gobierno y a otros el poder de acceder al dispositivo de cualquier persona para husmear y recopilar datos confidenciales. Desde entonces, la compañía ha avanzado hacia un cifrado aún más amplio de su hardware y software, para disgusto del FBI y otras agencias policiales. Aunque el cifrado de iCloud está activado de forma predeterminada, Apple podría escanear los archivos de cualquier usuario que solicite a la empresa que recupere sus datos, como cuando inician sesión en un nuevo dispositivo, restauran archivos desde una copia de seguridad o piden ayuda si pierden acceso a su cuenta.

Los defensores de la seguridad infantil dicen que el compromiso inquebrantable de Apple con la privacidad tiene un costo: Apple es esencialmente ciega al material ilegal y dañino almacenado en sus servicios. Como dijo un ex empleado a Forbes, esta postura “oculta otros daños sociales muy graves”. Los tecnólogos y veteranos de las fuerzas del orden dicen que los competidores en todos los ámbitos, desde Google, Meta y Microsoft hasta Dropbox y otros proveedores de nube personal, son mucho más proactivos a la hora de erradicar a los depredadores sexuales que abusan de sus plataformas. Cada año, esas empresas proporcionan millones (a veces decenas de millones) más ciberconsejos que Apple al NCMEC, que revisa y cataloga los consejos antes de entregárselos a los investigadores de abuso infantil.

"Nunca han estado realmente interesados en contribuir a la protección de los niños en su plataforma", dijo a Forbes Jim Cole, quien pasó dos décadas en la unidad de Investigaciones de Seguridad Nacional del DHS. "Han tomado el camino de la privacidad con bastante dureza y la ley no les exige buscar CSAM".

Apple se negó a comentar sobre una lista detallada de preguntas y, en cambio, proporcionó a Forbes una carta de Neuenschwander, director de privacidad del usuario y seguridad infantil de Apple, que abordaba las demandas recientes de la organización sin fines de lucro Heat Initiative para que Apple restableciera los planes de escanear sus sistemas en busca de CSAM. Neuenschwander dijo que Apple había abandonado el proyecto porque “no era prácticamente posible implementarlo sin poner en peligro la seguridad y privacidad de nuestros usuarios”, pero enfatizó que la compañía ofrece otras características de seguridad para combatir la explotación infantil.

El escaneo masivo de usuarios de Apple “[abriría] la puerta a la vigilancia masiva”, advirtió Neuenschwander en la carta, reportada por primera vez por Wired. “¿Cómo pueden estar seguros los usuarios de que una herramienta para un tipo de vigilancia no ha sido reconfigurada para vigilar otro contenido como actividad política o persecución religiosa? Las herramientas de vigilancia masiva tienen implicaciones negativas generalizadas para la libertad de expresión y, por extensión, para la democracia en su conjunto”. Añadió que los fallos en este tipo de escaneo podrían significar problemas para los padres "cuando no han hecho más que compartir fotografías perfectamente normales y apropiadas de sus bebés".

El enigma de iCloud

Desde diciembre de 2022, Apple ha proporcionado dos niveles de cifrado para iCloud. La "protección de datos estándar" cifra los datos en el servidor y en tránsito, pero Apple conserva las claves necesarias para descifrarlos. La "protección de datos avanzada" hace esencialmente lo mismo, pero Apple no puede recuperar los datos cifrados. Debido a que los usuarios deben optar explícitamente por esto último, es probable que Apple tenga acceso a una cantidad considerable de datos de iCloud no cifrados.

También maneja información no solo de sus propias aplicaciones, sino también de plataformas sociales, de mensajería y de correo electrónico de terceros donde los usuarios tienen activadas las copias de seguridad de sus dispositivos, algo que las fuerzas del orden a menudo notan cuando presentan solicitudes de orden judicial para buscar cuentas de iCloud. Eso incluye datos de WhatsApp de Meta y otros mensajeros centrados en la privacidad como Threema, así como aplicaciones como Kik que suelen utilizar los depredadores.

Es de suponer que Apple podría escanear iCloud con PhotoDNA, una de las herramientas más adoptadas en la lucha contra el material de explotación infantil en línea, dijo John Rouse, un veterano recientemente retirado con 25 años de experiencia en investigaciones de abuso infantil en Australia y ex presidente de Interpol Covert Internet. Grupo de Trabajo de Investigaciones. Creado en 2009 por Microsoft y Dartmouth College, el software convierte imágenes en valores numéricos únicos llamados hashes. Estos se pueden comparar con una base de datos de hashes CSAM conocidos. Una coincidencia inicia una mayor investigación.

PhotoDNA se usa tan ampliamente (Facebook y Google lo han estado usando durante más de una década, Snapchat desde al menos 2020) que es efectivamente un estándar de la industria. Pero es algo que Apple no ha adoptado. La compañía no realiza “ningún escaneo proactivo de sus tecnologías o sus almacenamientos, ni ninguna transmisión para ayudar a las autoridades a detener la explotación infantil, cero”, dijo Rouse. "No contribuyen".

Como todas las empresas de tecnología, Apple está obligada por ley a responder a las órdenes de registro y también debe informar a las autoridades federales el material de abuso sexual infantil que encuentre en sus plataformas a través de la “CyberTipline” administrada por el NCMEC.

El año pasado, mientras que Facebook e Instagram de Meta presentaron un total combinado de 26 millones de informes, Google 2 millones y TikTok casi 300.000, Apple presentó 234. El año anterior: 160.

Apple no es una empresa de redes sociales, por lo que ésta no es una comparación directa. Dicho esto, WhatsApp, que está cifrado de extremo a extremo, escanea contenido no cifrado, como fotos de perfil y de grupo, en busca de CSAM. Proporcionó más de 1 millón de ciberconsejos al NCMEC en 2022; Microsoft envió 110.000; Dropbox, casi 46.000; y Synchronoss, el proveedor de almacenamiento en la nube de Verizon, más de 30.000.

Apple declinó hacer comentarios sobre la escasez de informes del NCMEC en relación con sus pares. Si bien es probable que la discrepancia se deba en parte a duplicados (una sola imagen ofensiva compartida en varias publicaciones), los críticos dicen que es más un reflejo de que Apple no hace más de lo que está legalmente obligado a hacer para controlar el material ilegal.

El portavoz del NCMEC, Gavin Portnoy, dijo que la disparidad "no tenía nada que ver con una posible duplicación" y era el resultado de la falta de voluntad de Apple de "hacer esfuerzos razonables para detectar e informar CSAM en su plataforma". Incluso el sitio marginal 4chan, que no es el pináculo de la moderación, informa múltiples de lo que hace Apple cada año.

Y los documentos judiciales muestran que los servicios de Apple alojan CSAM. El caso de Mollick fue una de al menos 100 investigaciones federales realizadas entre 2014 y 2023 en las que se alegaba o se creía que el sospechoso había utilizado productos Apple para almacenar imágenes de explotación sexual de niños. (Ese recuento, que no incluye registros estatales, locales o internacionales, representa sólo una fracción del total de casos de explotación infantil que involucran a Apple).

Dos ejemplos: en 2022, el texano Michael Galván, de 42 años, fue condenado a más de 17 años de prisión por distribuir CSAM después de que se encontraran casi 600 vídeos e imágenes ilegales en su cuenta de iCloud. En mayo de este año, el ex maestro de escuela primaria del condado de Orange, Richard O'Connor, se declaró culpable de posesión de CSAM después de que una redada de su cuenta de iCloud identificara al menos 81 videos y 158 imágenes de abuso infantil, incluida “conducta violenta, sádica o masoquista”. " En ambos casos, Apple proporcionó datos en respuesta a órdenes de registro aprobadas por el tribunal. En el caso Galván, sin embargo, la pista original que inició la investigación nuevamente provino de Kik. En sólo dos de los casos revisados por Forbes, Apple detectó e informó proactivamente CSAM que detectó en mensajes de correo electrónico salientes.

Apple se negó a comentar sobre estos casos y las diferencias entre escanear correos electrónicos salientes en busca de imágenes de niños sexualmente explotadores y escanear iCloud. Pero es muy consciente de los problemas de CSAM en sus servicios. En mensajes de texto descubiertos durante el descubrimiento en Epic Games v. Apple, el jefe antifraude de Apple, Eric Friedman, le dijo a su colega en 2020 que Facebook y otras empresas de tecnología se habían centrado en la confianza y la seguridad, pero “apestaban” en la privacidad, y agregó que la privacidad de Apple es -un enfoque de derechos humanos fundamentales significó que se había convertido en "la mayor plataforma para distribuir pornografía infantil".

Un punto de inflexión

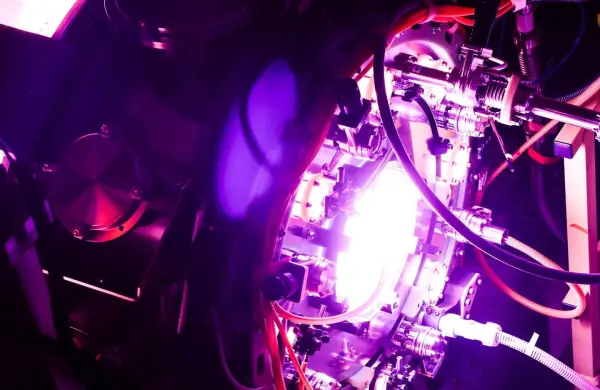

En un intento por detectar material ilegal alojado en iCloud, a finales de la década de 2010, Apple comenzó a trabajar en una herramienta que rastrearía sus servidores en busca de CSAM manteniendo la privacidad del cliente. Anunciado en agosto de 2021 y denominado NeuralHash, Apple dijo que el software podría detectar CSAM previamente identificado en el dispositivo, antes de cargarlo y sin mirar ni capturar ninguna información sobre fotos que no sean CSAM. La comunidad de seguridad infantil aplaudió la iniciativa. Pero un coro de voces aún más fuerte lo atacó, denunciando a NeuralHash como una grave amenaza a la privacidad.

A la cabeza de esa acusación estaba la Electronic Frontier Foundation, que describió la herramienta de Apple como “una puerta trasera a una mayor vigilancia y censura en todo el mundo”. Joe Mullin, el activista principal de la campaña de la organización sin fines de lucro contra Apple, argumentó que las técnicas propuestas para encontrar imágenes abusivas habrían llevado a una vigilancia generalizada de los usuarios de Apple. "Están tratando de localizar imágenes específicas que sean criminales, no hay duda al respecto, pero las técnicas que proponían usar eran como... hagamos del mundo entero un pajar y hagamos que un algoritmo lo revise", dijo Mullin a Forbes. También afirmó que las herramientas de escaneo suelen ser inexactas y no auditables.

Meredith Whittaker, presidenta de Signal, dijo a Forbes que los planes originales de Apple de realizar escaneos de fotografías guardadas en iCloud sin invadir la privacidad del usuario eran como "proponer magia en lugar de realidad". Apple lo dijo en la reciente carta de Neuenschwander, su director de privacidad del usuario y seguridad infantil, en respuesta a nuevas demandas para escanear fotos de iCloud en busca de CSAM. Fue la declaración más fuerte que Whittaker había visto del gigante tecnológico sobre el tema en 20 años de debate. "Fue inequívoco que esto nunca será posible", dijo Whittaker. Señaló investigaciones anteriores que encontraron vulnerabilidades en NeuralHash, afirmando que la tecnología podría potencialmente filtrar información sobre imágenes que no sean CSAM o ser explotada para incriminar a alguien.

"La declaración de Apple es la sentencia de muerte para la idea de que es posible escanear las comunicaciones de todos y preservar la privacidad", escribió en Twitter. “Apple tiene muchos de los mejores criptógrafos + software de ingeniería del mundo + $ infinitos. Si ellos no pueden, nadie podrá. (No pueden. Nadie puede)”.

La reacción pública a NeuralHash fue tan mala que Apple detuvo su implementación en el otoño de 2021 y luego la canceló en diciembre de 2022. La medida dejó a algunos de los que habían trabajado en el software consternados y frustrados. La herramienta fue “increíble”, dijo un ex empleado. “Fue revolucionario. Y requirió una enorme cantidad de trabajo”. Otro dijo: “No hicieron un gran trabajo al describirlo. No lo hicieron porque Apple no trae gente consigo. Les gusta sorprender y deleitar, pero no entienden que este tipo de cosas requieren que acompañes a la gente en cada paso”.

Un año después del anuncio, los directores Polinsky y Richardson se fueron; el primero se fue a trabajar para el Departamento de Justicia y el segundo saltó a GoFundMe. Bhowmick, el ingeniero líder en detección de CSAM, fundó su propia startup de seguridad, Samooha. El director de privacidad, Horvath, pasó al bufete de abogados Gibson, Dunn & Crutcher a principios de este año, mientras que el líder de la nube, Abbott, se fue en abril de este año a GM.

También estaban enojados por la revocación de Apple los defensores y funcionarios encargados de hacer cumplir la ley que vieron el lanzamiento de NeuralHash y el compromiso de la compañía con él como un gran paso adelante en la batalla contra la explotación infantil. Thorn, el grupo anti-CSAM respaldado por Kutcher, se encuentra entre los decepcionados de que Apple abandonara sus planes. "Cada tecnología se puede utilizar para el bien y para el mal, que es exactamente la razón por la que cada empresa de tecnología debería equilibrar la privacidad y la seguridad", dijo a Forbes la presidenta de Thorn, Julie Cordua. "Cuando no haces una cosa y sólo haces la otra, puedes abusar de tu tecnología".

Tampoco ayuda que el abandono de NeuralHash por parte de Apple parezca haber exacerbado la ya tensa relación entre la empresa y los investigadores de explotación infantil. Rouse dijo que Apple se había vuelto cada vez más "retraída". “No se comunican… no dialogan con nosotros”, dijo. "Y eso es realmente decepcionante cuando son uno de los mayores proveedores de tecnología del mundo".

Pero para los defensores de la privacidad, la decisión de Apple fue la única que pudo haber tomado, y NeuralHash fue una idea que debería haber abandonado antes. Incluso el fundador y director ejecutivo de Epic Games, Tim Sweeney, quien ha criticado públicamente a Apple como "una amenaza para la libertad en todo el mundo", entre otras cosas, elogió a la compañía por mantenerse firme frente a las críticas recientes. (Anteriormente calificó los ahora desaparecidos planes de Apple para la detección de CSAM como “software espía gubernamental instalado por Apple basado en una presunción de culpabilidad” y “una locura fuera de serie”).

"Un movimiento acertado por parte de Apple para resistir las campañas de presión para vigilar los documentos y comunicaciones privados de los usuarios en nombre de los gobiernos", escribió Sweeney en Twitter la semana pasada. "La propuesta de escaneo siempre fue una violación abominable de los derechos del cliente".

*Nota publicada originalmente en Forbes EE.UU. por Thomas Fox-Brewster y Alexandra S. Levine.