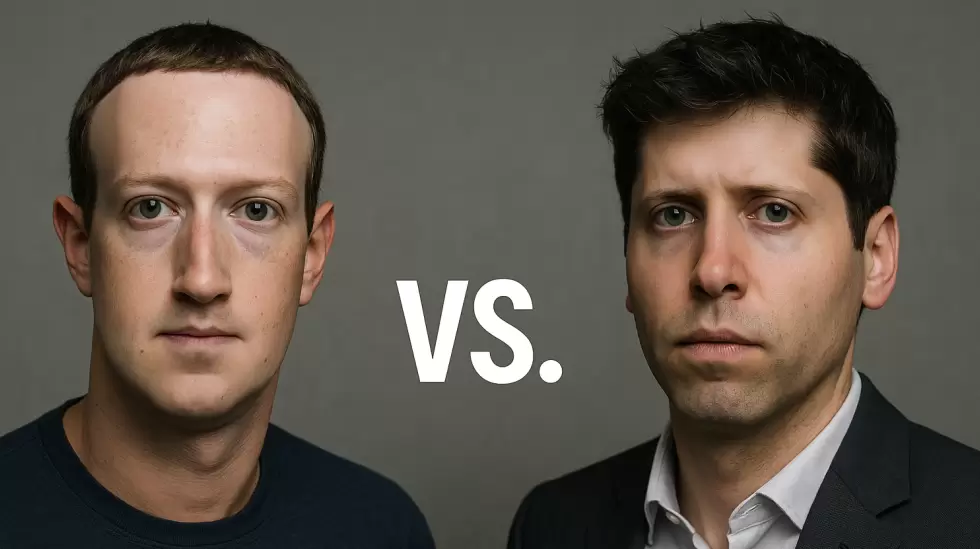

Hay un nuevo modelo de generación de imágenes en la ciudad, y para quienes siguen de cerca la interminable disputa entre Google y OpenAI en el terreno de los modelos de lenguaje, probablemente no sorprenda su origen.

Así es: Imagen GPT 1.5, de OpenAI, se lanzó esta semana y está integrado dentro del modelo GPT.

Hace poco, Google presentó Nano Banana Pro (y en su momento escribí sobre eso): un modelo con una precisión sorprendente para generar gráficos a partir de indicaciones mínimas, y con mejoras notables en el renderizado que llevaron a muchos a pensar que ya habíamos alcanzado el techo en cuanto a la generación de imágenes.

Creo que esto es la forma en que OpenAI le recuerda al mundo por qué se hizo conocida: en otras palabras, "nosotros también sabemos hacerlo".

Acá va una lista rápida de las cosas que la gente destaca de GPT Image 1.5:

- Seguimiento muy preciso de indicaciones complejas

- Una interfaz pensada para el usuario

- Conservación de detalles

- Velocidad

El modelo, igual que el reciente Nano Banana Pro, también recibe puntajes muy altos en la representación de texto. Esto es clave, porque como ya mencioné, cualquiera que haya usado DALL·E o Stable Diffusion hace un par de años recuerda que esos modelos solían generar un galimatías formado por letras y símbolos inexistentes. Incluso cuando los modelos de lenguaje dejaron de hacer eso, todavía no sabían ni escribir ni hablar correctamente.

Pero eso ya cambió.

Nuevos objetivos del modelo

"Al crear, deberías poder ver y dar forma a lo que estás creando", escribió Fidji Simo, integrante de la cúpula de OpenAI, en una publicación sobre esta nueva versión. "Cuando las imágenes cuentan una historia mejor que las palabras por sí solas, ChatGPT debería incluirlas. Cuando necesitás una respuesta rápida o el siguiente paso está en otra herramienta, debería estar ahí mismo. Al hacerlo, podemos seguir acortando la distancia entre lo que tenés en la mente y tu capacidad para darle vida", agregó.

Estas declaraciones dejan claro que Imagen 1.5 forma parte del conjunto más amplio de modelos que trabajan dentro del contexto de GPT-5.2 y sus capacidades.

Simo también detalla el origen del modelo y cómo piensan los equipos sobre su desarrollo:

En los últimos meses, hablé sobre cómo ChatGPT está dejando de ser un producto reactivo basado únicamente en texto para convertirse en una herramienta más intuitiva y conectada con cualquier tarea que quieras hacer. El paso del texto a una interfaz multimedia y dinámica es clave en esa transformación, y me entusiasma ver el progreso que estamos logrando.

Finalmente, Simo menciona algunos casos de uso y detalla cómo este modelo puede ofrecer los resultados que espera un usuario.

Cuando investigás sobre productos o restaurantes, no buscás solo una lista de opciones, sino también fotos y comparativas que te ayuden a decidir. Al aprender sobre temas nuevos, querés poder profundizar sin perder el hilo. Estamos mejorando las respuestas para sumar más elementos visuales, con fuentes claras y nuevas formas de ampliar el contexto.

Pronto, las respuestas empezarán a resaltar personas, lugares y productos relevantes, que vas a poder tocar para obtener más información al instante, sin necesidad de hacer otra pregunta. También vas a poder seleccionar cualquier palabra o frase en una respuesta, y ChatGPT te va a dar más datos al respecto.

Esta capacidad para investigar puede cambiar las reglas del juego.

Puntuación con los jueces

Algunos analistas prefieren un enfoque más numérico para evaluar Image 1.5, y le asignan puntajes en comparación con otros modelos recientes de generación de imágenes. En mi podcast favorito, AI Daily Brief, el conductor Nathaniel Whittemore repasó la puntuación que le dio LMArena, y sugirió que el modelo de OpenAI supera a Nano Banana en edición de imágenes. Además, mostró una ventaja notable de 29 puntos en la generación de texto dentro de las imágenes.

Por si te interesa: yo también lo probé. Y puedo decir que funciona muy bien.

La gran carrera

Hay algo que me parece importante destacar sobre estos modelos, y vale la pena tomarse un momento para pensar el contexto.

Nano Banana Pro es impresionante, igual que GPT Image 1.5. De hecho, ambos integran muchos de los mismos avances, si se tiene en cuenta la transición que estamos viendo en la inteligencia artificial tradicional hacia la IAG o los modelos de lenguaje de nivel superior.

Voy a cerrar con un fragmento de una reseña publicada en OfficeChai, titulada "El panorama competitivo", que resume bastante bien la situación. Son tres partes. Acá van las dos primeras:

Parte 1:

El lanzamiento de OpenAI refleja la creciente competencia en el campo de la generación de imágenes con inteligencia artificial. Los modelos Nano Banana de Google se destacaron no solo por su potencia técnica, sino también por su viralización: lograron que usuarios comunes se animaran a probar la creación de imágenes con IA. La respuesta de OpenAI apunta a muchas de esas mismas funciones, como la edición de imágenes, pero con mejoras claras: edición más precisa, mayor velocidad y un seguimiento más confiable de las instrucciones si se lo compara con versiones anteriores.

Es, en esencia, lo mismo que vengo planteando.

Parte 2:

La empresa reconoce que, aunque GPT Image 1.5 muestra mejoras evidentes frente a sus versiones anteriores en las pruebas internas, los resultados siguen siendo imperfectos y “aún hay un margen de mejora considerable en futuras iteraciones”.

Ese tono moderado contrasta con el entusiasmo que despertaron los modelos de Google, lo que quizás indica que OpenAI admite que todavía está intentando recuperar terreno en la percepción pública, aunque sus avances técnicos sigan en marcha.

Entonces, la empresa mantiene una postura realista sobre el ciclo de expectativas: resalta lo que logró, pero también deja en claro que todavía queda mucho camino por recorrer.

Parte 3:

Si ChatGPT Images logra recuperar el terreno perdido frente a Nano Banana Pro, no dependerá solo del rendimiento técnico. También será clave si OpenAI consigue generar el mismo efecto viral que llevó a las herramientas de Google al gran público. Por ahora, la compañía apuesta a que una edición más precisa y una experiencia de uso más pulida alcancen para volver a atraer a quienes usan estos modelos para editar imágenes y, sobre todo, para que se queden.

Y eso me hace ruido, en el buen sentido. Porque esto es, en el fondo, una economía de la atención. Los dos modelos son brillantes. Pero lo que va a marcar la diferencia es, justamente, la atención. Y eso está más vinculado a la marca y a cómo se capta la audiencia que a las especificaciones técnicas.

La otra gran pregunta es: ¿qué va a hacer la gente con todo esto?

Habrá que seguir atentos.